本篇目录:

kafkaAdminClient验证是否成功链接

使用代码进行测试。使用kafka版本0.0和使用javakafka-client0.0的使用者进行测试。一个客户正在消费该组中的主题,但是如果使用kill-9杀死活跃的消费者,则该组不会重新balancer到其他消费者。

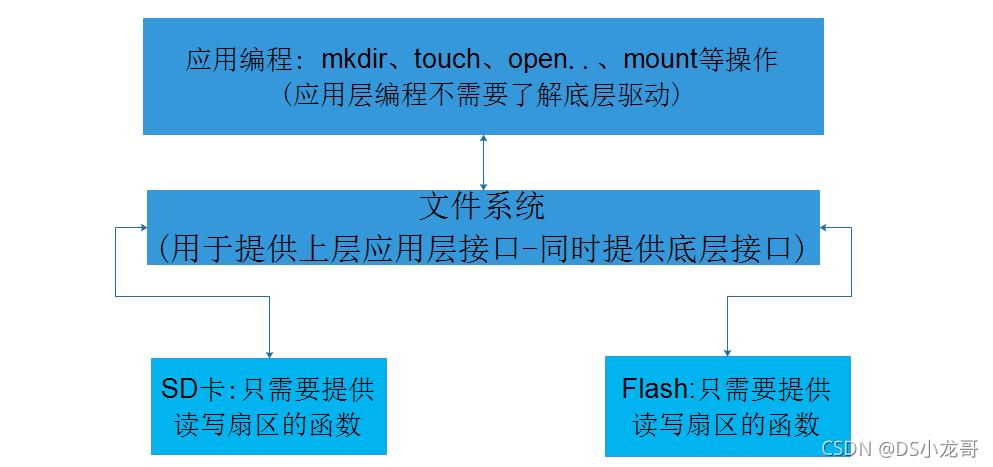

Kafka的五类客户端API类型如下:本文中,我们将主要介绍 AdminClient API。

系统故障,根据爱加速网官网查询得知。uc的知乎链接验证成功,但是进不去,是系统出现了短暂的故障,用户退出刷新后台再重启即可。

这应该是链接已经失效,只能重新申诉。百度账号申诉通过后,点击短信中的链接进入修改密保,链接只可以使用一次,有效期为3天,超出该时间链接自动失效,所以一旦申诉通过请及时修改密保信息。

小记一次Kafka集群响应慢问题追查

1、这种问题一般是比较头疼的,首先,我们Kafka集群都有监控和报警,通过查看可用性、流量变化、Kafka日志等方式,都没有发现任何异样;其次,响应慢也有可能和用户的使用方式和测试方法有关系。

2、消息队列指:一端进消息,一端出消息 RabbitMQ就是实现了消息队列概念的一个组件,以面向对象的思想去理解,消息队列就是类,而RabbitMQ就是实例,当然不仅仅只有RabbitMQ,例如ActiveMQ,RocketMQ,Kafka,包括Redis也可以实现消息队列。

3、kafka.acks = all,这里的ack有3个选项,0、all 。

4、acks=1:这个配置意味着kafka会把这条消息写到本地日志文件中,但是不会等待集群中其他机器的成功响应。acks=all:这个配置意味着leader会等待所有的follower同步完成。这个确保消息不会丢失,除非kafka集群中所有机器挂掉。

kafka低版本的怎么用java查询给定broker上所有的日志目录信息?

1、(1)在kafka集群中删除topic,当前topic被标记成删除。./kafka-topics.sh --zookeeper node3:2181,node4:2181,node5:2181 --delete --topic t1205 (2)在每台broker节点上删除当前这个topic对应的真实数据。

2、在 Kafka 0.0 以后,消息元数据中存在若的时间戳信息。如果 broker 端参数log.message.timestamp.type 设置为 LogAppendTIme ,那么时间戳必定能保持单调增。

3、Partition : Partition是物理上的概念,每个Topic包含一个或多个Partition。Producer : 负责发布消息到Kafka broker。Consumer : 消息消费者,向Kafka broker读取消息的客户端。

4、Kafka是由LinkedIn设计的一个高吞吐量、分布式、基于发布订阅模式的消息系统,使用Scala编写,它以可水平扩展、可靠性、异步通信和高吞吐率等特性而被广泛使用。

到此,以上就是小编对于kafka 批量消费的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏