本篇目录:

求助:solr如何通过指定条件修改数据

1、查询字符串 q 由以下元素项组成,字段条件形如 fieldName:value 格式:以上元素项的默认值由 solrconfig.xml 配置文件定义。通常查询时设置 q=*:* ,然后通过 fq 过滤条件来完成查询,通过缓存提高查询性能。

2、按照上面的配置即可,然后我们来看一下效果,首先是数据库:还是昨天的17条数据。

3、可以通过定时任务实现solr与数据库数据的的一致性、比如每天夜里某个时间点、对数据进行更新同步。

4、当然是刻意。Solr是基於lucene的一种技术,排序是由lucene实现的,如果你感兴趣,可以读一下lucene的书,或者一些基本的信息检索(Information retrieval)方面的文献。

5、q:查询的关键字,此参数最为重要,例如,q=id:1,默认为q=*:*,类似于sql中的where 1=1。 fq(filter query):过滤查询,提供一个可选的筛选器查询。

如何利用Spark提高批量插入Solr的效率

1、CheckPartitionTable规则执行类,需要通过引入sparkSession从而获取到引入conf;需要继承Rule[LogicalPlan];通过splitPredicates方法,分离分区谓词,得到分区谓词表达式。

2、当然我们也可以利用这个工具来做线上实时数据的入库或入HDFS,这时你可以与一个叫Flume的工具配合使用,它是专门用来提供对数据进行简单处理,并写到各种数据接受方(比如Kafka)的。

3、根据自己的业务需求,测试并选择合适的数据存储格式将有利于提高SparkSQL的查询效率。3 内存的使用 spark应用程序最纠结的地方就是内存的使用了,也是最能体现“细节是魔鬼”的地方。

4、当设置为true时,Spark SQL将为基于数据统计信息的每列自动选择一个压缩算法。spark.sql.inMemoryColumnarStorage.batchSize 10000 柱状缓存的批数据大小。

5、大数据是指无法在一定时间范围内用常规软件工具进行捕捉、管理和处理的数据集合。是需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力的海量、高增长率和多样化的信息资产。

6、Solr用Java编写、运行在Servlet容器(如Apache Tomcat或Jetty)的一个独立的企业级搜索应用的全文搜索服务器。

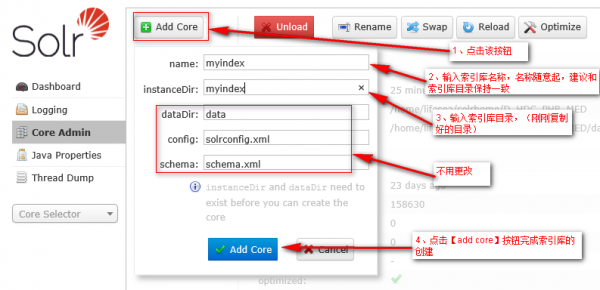

教你使用solr搭建你的全文检索

1、通过向 Solr 集群 GET 请求 /solr/core-name/select?query 形式的查询 API 完成查询,其中 core-name 为查询的 Core 名称。

2、正向索引(正排索引) :正排表是以文档的ID为关键字,表中记录文档中每个字的位置信息,查找时扫描表中每个文档中字的信息直到找出所有包含查询关键字的文档。

3、EgothorEgothor是一个用Java编写的开源而高效的全文本搜索引擎。借助Java的跨平台特性,Egothor能应用于任何环境的应用,既可配置为单独的搜索引擎,又能用于你的应用作为全文检索之用。

到此,以上就是小编对于的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏