本篇目录:

hbase是怎么进行读写的

1、所以hbase大多数读要走磁盘,所以读很慢。 每次刷写会生成新的Hfile,Hfile很小并且数量多的时候会影响查询的速度。所以要进行合并。

2、hbase客户端通过rpc调用将put、delete数据请求提交到对应的regionserver,regionserver对请求进行处理,并将数据最终写入hfile中,进行持久化保存。hbase为了保证随机读取的性能,所以hfile里面的rowkey是有序的。

3、HBase应用举例 Hbase适合需对数据进行随机读操作或者随机写操作、大数据上高并发操作,比如每秒对PB级数据进行上千次操作以及读写访问均是非常简单的操作。淘宝指数是Hbase在淘宝的一个典型应用。

4、通过合理设置key,如写入的时实时数据,但是读取的是昨天之前的数据,那么可以将时间戳作为key,Hbase会把不同时间的数据放到不同的region,达到读写分离。

5、HBase将数据分布在多台服务器上,通过水平扩展的方式来应对海量数据的存储需求。它使用了类似于Google的Bigtable的数据模型,将数据按照行和列的方式进行存储,支持快速的随机读写操作。

在hive下的为什么更新总是这样

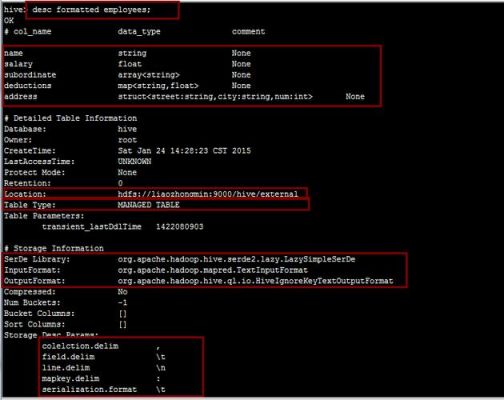

实际应用中,常常存在修改数据表结构的需求,比如:增加一个新字段。如果使用如下语句新增列,可以成功添加列col1。

hive一般只用于查询分析统计,而不能是常见的CUD操作,要知道HIVE是需要从已有的数据库或日志进行同步最终入到hdfs文件系统中,当前要做到增量实时同步都相当困难。和mysql,oracle完全不是相同的应用场景。

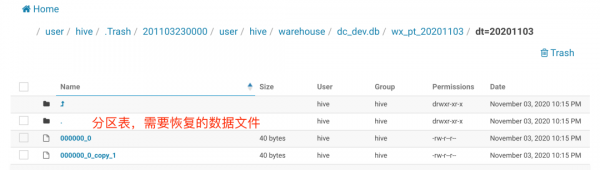

由于hive数仓的特性,不容许数据进行修改,造成hive中的数据更新活着删除很困难的问题,自hive 0.11版本之后,hive也尝试在测试环境允许进行update和delte操作,但这些操作还不成熟,不敢在生产环境放心使用,其中也有一样不足。

hbase(分布式、可扩展的NoSQL数据库)

HBase是一种分布式、可扩展的NoSQL数据库,它是基于Hadoop的HDFS文件系统构建的。HBase被设计用来处理海量数据,并提供高可靠性、高性能的读写操作。

HBase是一个基于Apache Hadoop的面向列的NoSQL数据库,是Google BigTable的开源实现。它运行在HDFS之上,为Hadoop提供类似于BigTable规模的服务。

HBase 是一个分布式的、面向列的开源数据库,该技术来源于 Fay Chang 所撰写的 Google 论文“Bigtable”:一个结构化数据的分布式存储系统。

有了HDFS(Hadoop Distributed File System)之后,确实可以满足大规模数据存储和处理的基本需求,它提供了跨机器的数据共享和数据分布式的存储能力。

HBase 是典型的 NoSQL 数据库,通常被描述成稀疏的、分布式的、持久化的,由行键、列键和时间戳进行索引的多维有序映射数据库,主要用来存储非结构化和半结构化的数据。

hbase使用标准的sql进行操作

1、如果要做的话。通常是使用hive(能够直接处理HBase中的数据),或者自己开发mapreduce程序;例子网上有很多。你这个逻辑如果不很复杂,通过hive简单些,写几条语句就搞定。另:如果就是验证下功能,那做做没问题。

2、目前主流的数据库或者NoSQL要么在CAP里面选择AP,比较典型的例子是Cassandra,要么选择CP比如HBase,这两个是目前用得非 常多的NoSQL的实现。

3、对HBase的读写操作,实际上就是对这张表进行增删改查操作。 对于写操作,HBase提供了Put操作。一个Put操作就是一次写操作,它将指定Row Key的数据写入到HBase中。

4、HBase Shell:HBase自带的命令行工具,可以进行数据的增删改查、表的创建和删除等操作。 HBase Web UI:HBase自带的Web界面,可以进行表的创建和删除、数据的查询和导出等操作。

5、步骤4:启动HBase 执行命令`start-hbase.sh`启动HBase集群,执行命令`jps`可以查看HBase的进程是否正常启动。HBase的基本操作 创建表 使用HBaseShell或HBaseAPI可以创建表,需要指定表的名称和列族。

6、StandaloneMode 默认的运行模式。在该模式下,Hbase不会使用HDFS,而是使用本地文件系统。它在同一个虚拟机中运行所有Hbasedaemon和本地ZooKeeper。ZooKeeper绑定一个众所周知的端口,所以客户端可以和Hbase通讯。

六、HBase写入流程

1、整个写入顺序图流程如下:1 客户端查找对应region 客户端根据要操作rowkey,查找rowkey对应的region。查找region的过程为通过zk获取到hbase:meta表所在region。

2、和读相比,HBase写数据流程倒是显得很简单:数据先顺序写入HLog,再写入对应的缓存Memstore,当Memstore中数据大小达到一定阈值(128M)之后,系统会异步将Memstore中数据flush到HDFS形成小文件。

3、首先Hbase是依赖于HDFS和zookeeper的。 Zookeeper分担了Hmaster的一部分功能,客户端进行DML语句的时候,都是先跟ZK交互。

4、使用bulk load功能最简单的方式就是使用importtsv 工具。importtsv 是从TSV文件直接加载内容至HBase的一个内置工具。它通过运行一个MapReduce Job,将数据从TSV文件中直接写入HBase的表或者写入一个HBase的自有格式数据文件。

5、该过程会自动从指定hbase表内一行一行读取数据进行处理。

到此,以上就是小编对于hbase批量删除数据的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏